英伟达近期在视觉-语言模型领域取得了重大突破,推出了一款名为Eagle 2.5的新型模型。这款模型专注于长上下文多模态学习,特别擅长处理大规模视频和图像。

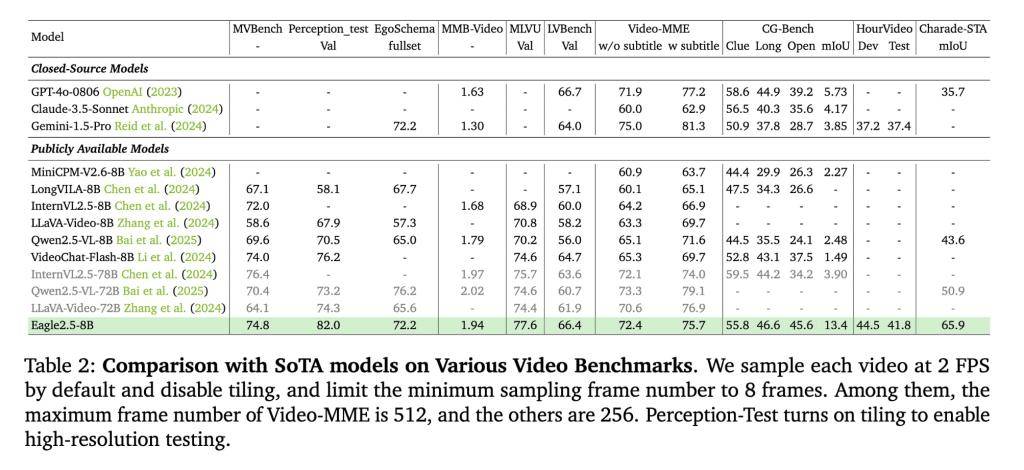

Eagle 2.5尽管参数规模仅为8B,但在Video-MME基准测试中展现出了惊人的性能。在处理512帧输入的测试中,它获得了72.4%的高分,这一成绩足以媲美规模更大的模型,如Qwen2.5-VL-72B和InternVL2.5-78B。这一成绩的背后,离不开英伟达在模型训练策略上的创新。

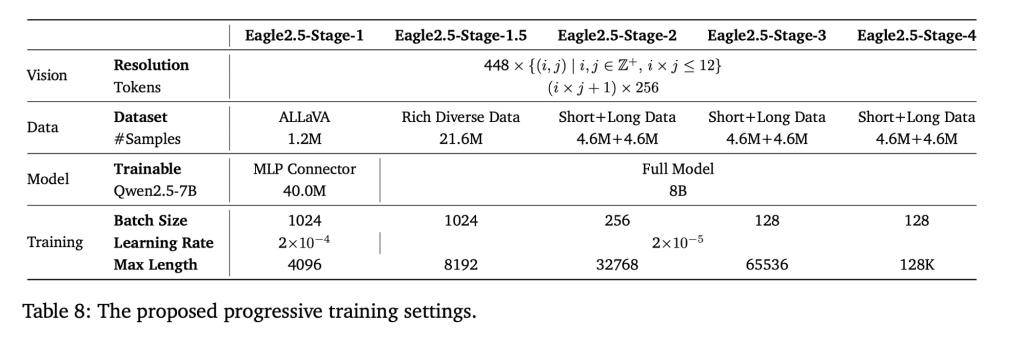

为了提升模型的性能,英伟达采用了两项关键训练策略:信息优先采样和渐进式后训练。信息优先采样技术通过图像区域保留和自动降级采样,确保了原始图像区域的完整性和视觉细节的优化。同时,渐进式后训练策略通过逐步扩展模型上下文窗口,让模型在不同输入长度下都能保持稳定性能,避免了过拟合单一上下文范围的问题。

Eagle 2.5的训练数据管道也经过了精心设计。英伟达整合了开源资源和定制数据集Eagle-Video-110K,该数据集专为理解长视频设计,采用了双重标注方式。通过自上而下的故事级分割和自下而上的问答对生成,数据集在强调多样性的同时,确保了叙事连贯性和细粒度标注,为模型在高帧数任务中的表现提供了有力支持。

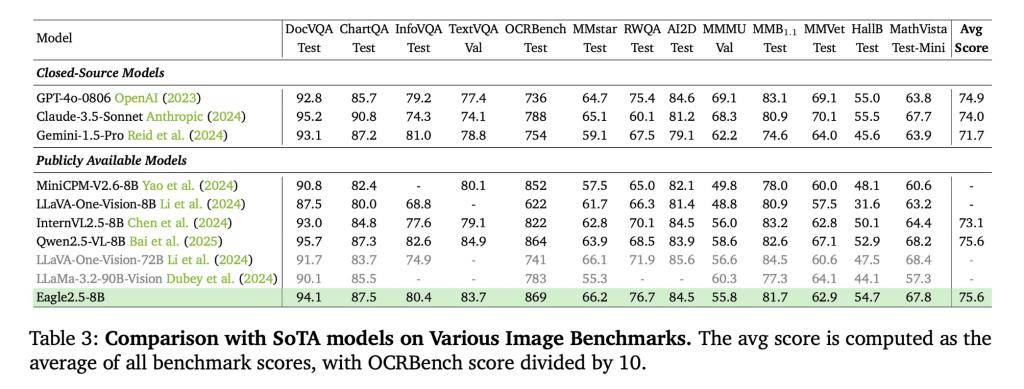

在性能表现方面,Eagle 2.5-8B在多项视频和图像理解任务中都展现出了卓越的性能。在视频基准测试中,它在MVBench、MLVU和LongVideoBench上分别获得了74.8、77.6和66.4的高分。在图像基准测试中,它在DocVQA、ChartQA和InfoVQA上也分别取得了94.1、87.5和80.4的优异成绩。这些成绩充分证明了Eagle 2.5在视觉-语言模型领域的领先地位。

为了进一步验证模型的有效性,英伟达还进行了消融研究。研究结果表明,移除信息优先采样和自动降级采样技术会导致模型性能下降。而加入渐进式训练和Eagle-Video-110K数据集则能带来更稳定的性能提升。这一结果进一步证明了英伟达在模型训练策略和数据集设计上的正确性。